EUR-Lex Access to European Union law

This document is an excerpt from the EUR-Lex website

Document C:2008:026:FULL

Official Journal of the European Union, C 26, 30 January 2008

Diario Oficial de la Unión Europea, C 26, 30 de enero de 2008

Diario Oficial de la Unión Europea, C 26, 30 de enero de 2008

Display all documents published in this Official Journal

|

ISSN 1725-244X |

||

|

Diario Oficial de la Unión Europea |

C 26 |

|

|

||

|

Edición en lengua española |

Comunicaciones e informaciones |

51o año |

|

Número de información |

Sumario |

Página |

|

|

IV Informaciones |

|

|

|

INFORMACIONES PROCEDENTES DE INSTITUCIONES Y ÓRGANOS DE LA UNIÓN EUROPEA |

|

|

|

Tribunal de Cuentas |

|

|

2008/C 026/01 |

||

|

ES |

|

IV Informaciones

INFORMACIONES PROCEDENTES DE INSTITUCIONES Y ÓRGANOS DE LA UNIÓN EUROPEA

Tribunal de Cuentas

|

30.1.2008 |

ES |

Diario Oficial de la Unión Europea |

C 26/1 |

INFORME ESPECIAL N o 9/2007

sobre «La evaluación de los programas marco de investigación y de desarrollo tecnológico (IDT) de la UE — ¿Podría mejorarse el enfoque de la Comisión?, » acompañado de las respuestas de la Comisión

(presentado en virtud del artículo 248 CE, apartado 4, párrafo segundo)

(2008/C 26/01)

ÍNDICE

|

I-V |

RESUMEN |

|

1-14 |

INTRODUCCIÓN |

|

1-7 |

Papel de la Unión Europea en el fomento de las acciones de IDT |

|

8-14 |

Evaluación y seguimiento de los programas marco |

|

15-18 |

ALCANCE Y ENFOQUE DE LA FISCALIZACIÓN |

|

19-109 |

OBSERVACIONES DE LA FISCALIZACIÓN |

|

19-37 |

Lógica de intervención, definición de los objetivos e indicadores de rendimiento |

|

38-49 |

Estrategia de evaluación |

|

50-68 |

Organización de la evaluación de los programas marco |

|

69-97 |

Metodologías y técnicas de evaluación |

|

98-109 |

Difusión y utilización de las constataciones de evaluación |

|

110-118 |

CONCLUSIÓN GENERAL |

Anexo I: Determinación del impacto y de los resultados de la intervención pública en IDT

Anexo II: Disposiciones en materia de seguimiento y de evaluación en las decisiones legislativas relativas a los programas marco IV a VII

Anexo III: Principales diferencias de la evaluación ex post de los programas de investigación entre la UE (IV a VII programas marco), Estados Unidos y Canadá

Anexo IV: Posible estructura del panel de expertos del VII PM

Respuestas de la Comisión

RESUMEN

|

I. |

Los programas marco comunitarios de IDT constituyen la más importante fuente de financiación pública en materia de investigación en la Unión Europea. La Comisión se encarga de la gestión de estos programas y de la evaluación de sus resultados. |

|

II. |

La fiscalización tuvo como objeto los sistemas de seguimiento y evaluación en vigor desde 1995 para los tres últimos períodos de programación (IV PM, V PM y VI PM), y también presenta una visión general del VII PM (2007-2013). La fiscalización contó con la participación del Tribunal de Cuentas de la AELC y con el apoyo de expertos externos. |

|

III. |

El objetivo de la fiscalización ha sido determinar si el enfoque adoptado por la Comisión para evaluar los resultados de los programas marco es el adecuado. En este contexto, el Tribunal verificó si la Comisión respetaba las obligaciones jurídicas relativas a la evaluación y si su sistema de evaluación y seguimiento respondía adecuadamente a las expectativas de las partes interesadas. El Tribunal examinó en particular si:

|

|

IV. |

Las constataciones y conclusiones del Tribunal fueron las siguientes:

|

|

V. |

El Tribunal recomienda lo siguiente:

|

INTRODUCCIÓN

Papel de la Unión Europea en el fomento de las acciones de IDT

|

1. |

La investigación y el desarrollo tecnológico (IDT) (1) constituyen el principal motor del progreso científico y tecnológico, así como de la innovación, y como tales contribuyen particularmente a la mejora del nivel de vida. La intervención pública en el ámbito de la IDT se justifica generalmente como medida correctora para paliar las denominadas «deficiencias del mercado», es decir, que las ayudas públicas contribuyen a reducir las incertidumbres, y son una fuente de inversión cuando la investigación representa un bien público o cuando existen importantes externalidades. |

|

2. |

El artículo 163 del Tratado constitutivo de la Comunidad Europea define el papel de la Comunidad en el fomento de la IDT, ya que prevé que «la Comunidad tiene como objetivo fortalecer las bases científicas y tecnológicas de su industria y favorecer el desarrollo de su competitividad internacional, así como fomentar todas las acciones de investigación que se consideren necesarias…». Los artículos 164 a 173 determinan las acciones que deberán llevarse a cabo en este ámbito, así como el campo de aplicación y la ejecución de los programas marco plurianuales de IDT. La Comisión se encarga de presentar propuestas de programas marco, mientras que las decisiones relativas a los mismos y las normas en materia de participación y de difusión son adoptadas según el procedimiento de codecisión por el Parlamento Europeo y por el Consejo. En cambio, los programas específicos son adoptados sólo por el Consejo. Los programas marco son ejecutados por seis direcciones generales conjuntamente, las denominadas «direcciones generales de investigación» (2). |

|

3. |

Entre la amplia gama de políticas desarrolladas en la Unión Europea con el objetivo de reforzar la innovación y la competitividad, los programas marco constituyen el instrumento financiero más importante en cuanto a su contribución a la estrategia de Lisboa (3) y al objetivo de Barcelona (4) a nivel comunitario.

|

|

4. |

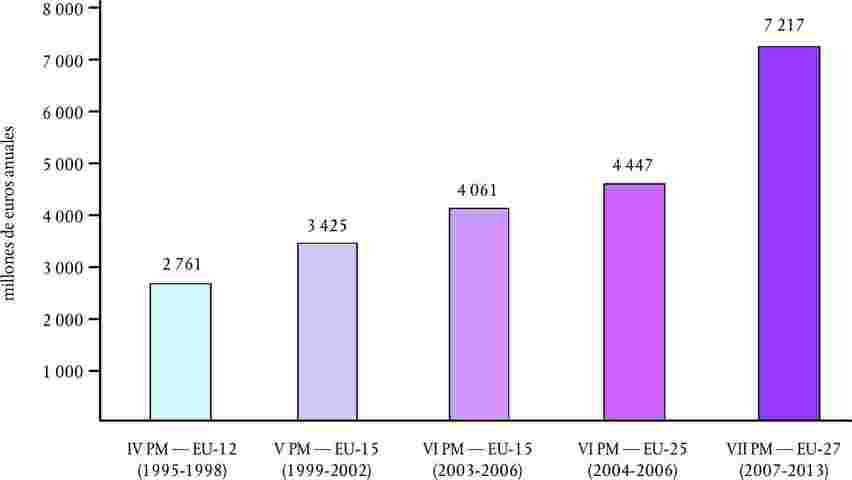

A través de los programas marco, la Comunidad otorga financiación a los investigadores de la Unión Europea, de los países asociados y de los organismos internacionales. Los presupuestos de estos programas han experimentado un incremento considerable a lo largo de los años, alcanzando 7 217 millones de euros anuales con el VII PM, frente a los 2 761 millones de euros en el marco del IV PM (véase el gráfico 1). En términos de créditos presupuestarios, representan el mayor ámbito de gestión directa y centralizada en la Comisión (5). |

|

5. |

Los programas marco, a diferencia de muchos programas nacionales, abarcan tanto la investigación fundamental como la investigación aplicada, y en ellos participan empresas y organismos públicos de investigación (6). Están compuestos de varios programas (y subprogramas) específicos que tienen como objeto amplios ámbitos científicos. A su vez, estos programas se subdividen generalmente en diversas áreas centradas en una rama científica más concreta. A continuación, tras un procedimiento de licitación, estas áreas se ejecutan a través de proyectos (denominados «acciones indirectas»), financiándose así cientos de proyectos específicos por área. |

|

6. |

La contribución global de los programas marco en el conjunto de la financiación pública de IDT en la Unión Europea y en sus Estados miembros oscila entre un 4 % y un 5 %. Sin embargo, su impacto en el tipo de acciones de investigación llevadas a cabo en Europa resulta mucho más importante. En efecto, por lo general las subvenciones comunitarias solo financian los proyectos parcialmente. Además, cuando solicitan financiación, los investigadores deben demostrar que sus proyectos están orientados hacia los objetivos formulados en las licitaciones. Así pues, los programas marco constituyen un incentivo para que las acciones de IDT se orienten hacia objetivos comunitarios específicos. |

|

7. |

En los últimos años se han producido grandes cambios en los programas marco, debidos a:

|

Evaluación y seguimiento de los programas marco

|

8. |

La Comisión se encarga de la ejecución de los programas y de la evaluación de sus resultados (8). Dentro de esta institución, las direcciones generales llevan a cabo la evaluación de forma descentralizada, mientras que los servicios centrales (en particular, la Dirección General de Presupuestos y la Secretaría General) se encargan del apoyo y de la coordinación. |

|

9. |

Las definiciones utilizadas en el presente informe son las acuñadas por la Comisión: por «evaluación» se entiende «juicio sobre las actuaciones, teniendo en cuenta los resultados, los efectos y las necesidades que se pretendía satisfacer» (9), y se habla de «seguimiento» cuando se facilita información sobre la ejecución de los programas y proyectos en curso con el fin de proveer a las necesidades de gestión (10). Esta constituye también la definición y distinción de ambas actividades en la legislación vigente relativa al VII PM. |

|

10. |

En lo sucesivo, se emplearán los términos siguientes para describir los resultados de las acciones de IDT:

Recuadro 1Ejemplo del «Sistema global para comunicaciones móviles» (GSM)En este caso, las «realizaciones» de la financiación comunitaria correspondían a los resultados inmediatos del proyecto, como la elaboración del estándar GSM. Los «logros» constituían su aceptación como norma de telefonía celular digital en los países europeos y en otros países, lo que ha contribuido en gran medida al desarrollo del sector de las telecomunicaciones. Por último, el «impacto» lo constituyeron las consecuencias económicas, sociales y políticas de la aplicación de esta tecnología a nivel internacional. Entre ellas figuran la contribución a la creación de empleo en el sector de las telecomunicaciones y en sectores conexos, así como el auge de este sector para la economía europea. A la larga, el sistema GSM también ha proporcionado un nuevo medio de comunicación interpersonal. |

|

11. |

No obstante, la apreciación de estos resultados plantea diversas dificultades metodológicas (véase el anexo I). Los cambios socioeconómicos se caracterizan por su complejidad y, en concreto, a menudo resulta difícil establecer la relación entre una actividad de investigación y los efectos e impactos que se observan. Pese a constituir un desafío considerable, estas dificultades metodológicas no impiden necesariamente una evaluación eficaz. |

|

12. |

Desde los años ochenta, la Comisión puso en funcionamiento un sistema de seguimiento y evaluación de los programas marco (11). A partir del IV PM, a mediados de los años noventa, el sistema de seguimiento y evaluación consistía en una serie de actividades parcialmente relacionadas, entre las que figuran:

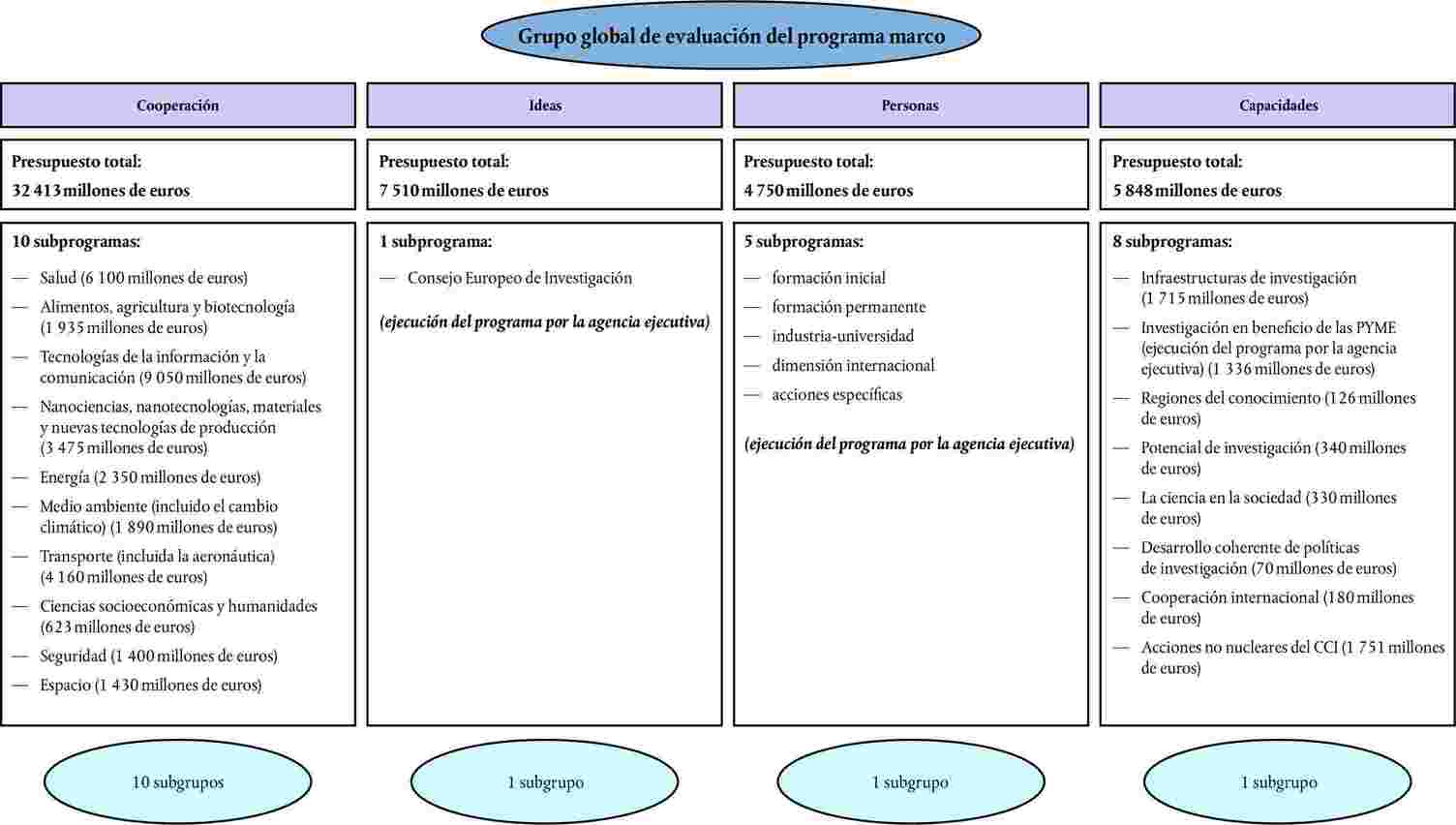

Ambas actividades tuvieron que llevarse a cabo con la asistencia de expertos externos (véase el gráfico 2 y el anexo II). Gráfico 2 Principales disposiciones relativas al seguimiento y a la evaluación de los programas marco IV-VII

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

13. |

Hasta la fecha, se han realizado tres evaluaciones quinquenales (12), que han dado lugar a los informes «Davignon», «Majó» y «Ormala» (en 1997, 2000 y 2004 respectivamente). Por otra parte, la Dirección General de Sociedad de la Información llevó a cabo evaluaciones con objetivos determinados de su programa específico. Cabe señalar que las evaluaciones quinquenales se han interrumpido tras la adopción de la legislación relativa al VII PM, eliminando así la limitación que suponía centrar los principales ejercicios de evaluación en los cinco años anteriores y, por tanto, abarcar parcialmente dos períodos de programación sucesivos. En 2004, también se publicó el informe «Marimón» (13), que evalúa específicamente la efectividad de los nuevos instrumentos introducidos en el marco del VI PM. |

|

14. |

En 2000 y en 2002 (14) se revisó el marco de las actividades de evaluación de la Comisión. Estas comunicaciones se actualizaron en 2007 tomando en consideración las implicaciones de la reforma administrativa de la Comisión y del nuevo Reglamento financiero (15). En estos documentos se describe el papel y la función de la evaluación en el contexto del ciclo global de planificación, programación y elaboración de informes de la Comisión, y se hace mención de un conjunto de 21 normas de evaluación y 18 modelos de «buenas prácticas». Además, los mencionados documentos tratan el uso de la evaluación en el proceso de preparar y simplificar la legislación de la UE. |

ALCANCE Y ENFOQUE DE LA FISCALIZACIÓN

15. El objetivo principal de la fiscalización ha consistido en determinar si la Comisión aplicaba un enfoque adecuado para apreciar los resultados de los programas marco de IDT.

|

16. |

Con este fin, el Tribunal comprobó en qué medida:

|

|

17. |

El presente informe analiza los sistemas de evaluación aplicables relativos a los IV PM (1995-1998), V PM (1999-2002) y VI PM (2003-2006). También aborda las obligaciones jurídicas actualmente en vigor en el VII PM (2007-2013), pero no proporciona una apreciación de la «Evaluación de impacto y evaluación ex ante del VII PM» de la Comisión (16). Además, se centra particularmente en el seguimiento y en la evaluación ex post de los programas, y no en la evaluación ex ante de las propuestas de proyectos ni en la evaluación ex post de los proyectos propiamente dichos. |

|

18. |

La fiscalización contó con la participación del Tribunal de Cuentas de la AELC y con el apoyo de expertos externos. Las pruebas de auditoría se obtuvieron mediante:

|

OBSERVACIONES DE LA FISCALIZACIÓN

Lógica de intervención, definición de los objetivos e indicadores de rendimiento

|

19. |

Para que la evaluación y el seguimiento sean eficaces, conviene determinar, a nivel de la política, del programa y del proyecto, unos objetivos claros y unos indicadores de rendimiento pertinentes que permitan evaluar los resultados de una intervención pública. Buenas prácticas en otros ámbitos presupuestarios de la UE y de otros países indican que estos objetivos e indicadores deberían fijarse en el marco de una lógica de intervención. |

|

20. |

La lógica de intervención puede definirse como un conjunto de vínculos hipotéticos de causa y efecto que describen de qué forma una intervención puede alcanzar sus objetivos globales (19). Las directrices de la Comisión en materia de evaluación indican que la lógica de intervención establece el vínculo conceptual desde los recursos de una intervención hasta la obtención de sus realizaciones y, posteriormente, hasta su impacto en la sociedad en términos de resultados y logros (20). Esta es la definición utilizada en el presente informe. |

|

21. |

El Tribunal evaluó en qué medida se estableció una lógica de intervención en los programas marco y en sus programas constitutivos, obteniéndose así una base sólida para la evaluación y el seguimiento. |

La lógica de intervención en el caso de los programas marco no ha sido explícita

|

22. |

Desde el principio, la definición de una lógica de intervención debería constituir un elemento clave de la concepción de un programa. El artículo 163 del Tratado, que prevé la necesidad de fortalecer las bases científicas y tecnológicas y de favorecer el desarrollo de la competitividad, debería servir de punto de partida para esta lógica de intervención en los programas marco (véase el apartado 2). Dicha lógica debería alcanzar un mayor nivel de concretización en lo que respecta a los distintos ámbitos científicos objeto de los programas marco y a los diversos instrumentos empleados. |

|

23. |

Sin embargo, no existe a ningún nivel un modelo lógico explícito que permita esclarecer de qué modo los programas marco y sus programas constitutivos contribuyen al progreso e innovación científicos y tecnológicos. |

|

24. |

El panel de expertos encargado de la evaluación quinquenal de 2004 también hizo hincapié en la falta de una lógica de intervención en el caso de los programas marco y afirmó que «[…] de paneles como el nuestro se espera que salven la distancia entre, por un lado, los elementos probatorios recopilados principalmente a nivel del proyecto y, por otro, los objetivos socioeconómicos de alto nivel de la política de investigación. Sin embargo, en la actualidad resulta difícil establecer este vínculo debido a la forma en que se planifican los programas marco. Ninguna lógica explícita relaciona los objetivos más ambiciosos con los objetivos específicos en términos de investigación y de conocimientos» (21). |

|

25. |

Un enfoque distinto es adoptado en algunos Estados miembros (por ejemplo, los Países Bajos y Finlandia) y en los EE.UU. (véase el gráfico 3), donde la definición de una lógica de intervención resulta mucho más frecuente, así como en Canadá, donde es obligatoria para todos los programas (véase el anexo III). Efectivamente, en estos países el recurso a la lógica de intervención en la fase de concepción del programa ha permitido elaborar unos programas con objetivos más precisos y mejor estructurados. La Comisión integra también esta lógica en otros ámbitos de las políticas comunitarias (por ejemplo, las ayudas exteriores) (22). Gráfico 3 Definición de una jerarquía de objetivos basada en modelos lógicos: ejemplo de investigación en el sector agrícola en Estados Unidos

|

|||||||||||||||||||||||||||

|

26. |

La eficacia de la evaluación y del seguimiento de los programas marco se ve menoscabada por el hecho de que no se formule el razonamiento subyacente a la intervención pública y los supuestos vínculos de causalidad (que sirven de base para la planificación detallada, ejecución y evaluación del programa). Esta deficiencia se debe en particular a la manera de definir los objetivos de los programas y los indicadores de rendimiento. |

Sin un modelo lógico explícito resulta más difícil establecer objetivos de programa coherentes

|

27. |

Si el razonamiento subyacente a la intervención pública no se formula de manera explícita, resulta más difícil definir y estructurar los objetivos del programa de forma coherente. Varios elementos ilustran esta constatación:

|

|

28. |

La Comisión ha intentado presentar los objetivos operativos en los programas de trabajo basándose en los objetivos de los programas definidos en la legislación relativa a los programas marco. Sin embargo, prácticamente en todos los casos, estas iniciativas no han permitido aclarar la lógica subyacente a estos programas y los objetivos indicados en el programa no eran específicos, mensurables, realizables, pertinentes y con fecha determinada. En 2003, esto pasó a ser un requisito legal en virtud del Reglamento Financiero (23). |

|

29. |

No resulta fácil discernir en qué medida es posible identificar los objetivos políticos a través de los programas específicos, de los programas de trabajo y de las licitaciones para los distintos proyectos cofinanciados por la Comunidad. A menos que se clarifiquen dichos vínculos, no resultará posible evaluar la contribución de los programas marco y de sus programas constitutivos a la consecución de estos objetivos políticos. La fiscalización puso de relieve que, en sus evaluaciones, la Comisión había proporcionado elementos justificativos escasos, o no convincentes, sobre la consecución de los objetivos a más largo plazo, tanto a nivel de proyectos como de programas (véase el apartado 82). |

La falta de una lógica de intervención explícita y de objetivos claros dificulta la fijación de indicadores de rendimiento

|

30. |

La inexistencia de un modelo lógico explícito y de objetivos de programa claramente formulados también ha obstaculizado la elaboración de indicadores de rendimiento para supervisar la consecución de los objetivos del programa en términos de realizaciones, logros e impacto, en la medida en que, hasta la fecha, tales indicadores de «eficacia» no se han definido en absoluto para los programas marco (véase el apartado 73). |

|

31. |

En esta situación, el examen de los proyectos en curso financiados por estos programas y la evaluación a posteriori de los proyectos que ya han llegado a su término son también más difíciles y complican la agrupación de las evaluaciones desde el nivel del proyecto hasta el del programa (véase el anexo I y el apartado 84). |

Tal y como son actualmente aplicados, los sistemas de presupuestación por actividades/gestión por actividades no constituyen herramientas adecuadas para apreciar el rendimiento de los programas marco

|

32. |

Algunos indicadores de la eficiencia de la ejecución de los programas (por ejemplo, los plazos de firma de los contratos y los plazos de pago) figuran en los informes anuales de seguimiento de la Comisión y están presentes en el sistema de gestión por actividades de esta institución. |

|

33. |

Sin embargo, hasta la fecha, las «direcciones generales de investigación» no han aplicado ninguna nomenclatura normalizada o comparable para la presupuestación por actividades, ni ningún indicador conexo, incluso cuando ejecutan el mismo programa (o subprograma) específico. Por consiguiente, estos indicadores no pueden emplearse para comparar el rendimiento entre los programas ni dentro de los mismos. Recuadro 2El Principio de presupuestación por actividades/gestión por actividades aplicado actualmente por las «direcciones generales de investigación»Según el principio de presupuestación por actividades/gestión por actividades, los programas marco corresponden a dos ámbitos políticos distintos en los cuales sus actividades se presentan en función de una nomenclatura diferente, específica a cada dirección general (24). Este es también el caso de los programas y subprogramas específicos ejecutados por varias direcciones generales. Los objetivos de la gestión por actividades se definieron a partir de distintos principios subyacentes (25) y, como indica el servicio de auditoría interna de la Comisión (26), se formularon principalmente en términos generales, mediante la descripción de aspiraciones o de actividades. Por lo general, los indicadores se centraban en los recursos disponibles (por ejemplo, número de reuniones, etc.) y algunos tenían en cuenta la eficiencia del proceso (por ejemplo, los plazos de firma de los contratos y los plazos de pago), pero no resultaba posible realizar una comparación entre los programas y entre las direcciones generales debido a las diferencias en la nomenclatura de la presupuestación por actividades, en las hipótesis propias a cada dirección general (como el inicio y el término de procesos administrativos específicos) y en la población subyacente tomada en consideración para su cálculo (por ejemplo, tipo de convenio de subvención y tipo de pago). |

Recomendaciones

34. En sus futuras propuestas legislativas al Consejo y al Parlamento Europeo, la Comisión debería definir una lógica de intervención explícita para el conjunto del programa marco, así como para sus partes constitutivas. 35. Con respecto al VII PM, la Comisión debería: — describir claramente los objetivos del programa marco y de sus programas (y subprogramas) específicos constitutivos, así como las modalidades de su realización, — precisar el vínculo entre los objetivos científicos y socioeconómicos para cada programa (y subprograma) específico, — definir los objetivos operativos pertinentes. 36. En su sistema de seguimiento del VII PM, la Comisión debería establecer, para cada programa (y subprograma) específico, una serie limitada, pero equilibrada, de indicadores de rendimiento que permita medir la «eficiencia» y la «eficacia» de la ejecución de los programas. 37. Las «direcciones generales de investigación» deberían armonizar su nomenclatura de gestión por actividades/presupuestación por actividades para que los indicadores de rendimiento puedan ser objeto de comparaciones a nivel temporal y, cuando resulte posible, entre programas (y subprogramas) específicos.

Estrategia de evaluación

|

38. |

Una estrategia de evaluación proporciona el marco conceptual en el que se conciben, planifican, ejecutan y utilizan las actividades de evaluación. Las buenas prácticas en otros ámbitos presupuestarios de la UE y en otros países parecen indicar que dicha estrategia debería tener en cuenta las principales cuestiones jurídicas, organizativas y metodológicas en torno a la evaluación de los programas, en concreto, las evaluaciones que deben realizarse, los responsables de las mismas, su calendario, las modalidades de obtención de datos, los enfoques metodológicos que deben aplicarse y las modalidades de comunicación y de seguimiento de los resultados. |

|

39. |

Disponer de una estrategia de estas características y asegurarse de su ejecución, constituyen condiciones previas a la integración de la evaluación en la cultura organizativa y en el proceso decisorio de la Comisión. No obstante, el Tribunal reconoce que, a raíz de la diversidad de los ámbitos científicos cubiertos por los programas marco, esta estrategia tendría que ofrecer un nivel de flexibilidad apropiado a cada una de las direcciones generales responsables y no debería ser demasiado preceptiva. |

|

40. |

El Tribunal comprobó en qué medida la Comisión ha establecido este tipo de estrategia de evaluación para los programas marco. |

Ausencia de una estrategia de evaluación global para los programas marco

|

41. |

En el caso de los programas marco, la Comisión dio a conocer por primera vez su enfoque de la evaluación en los años ochenta (27). Este fue actualizado en 1996, cuando comunicó al Parlamento Europeo y al Consejo lo que consideró como principios pertinentes subyacentes al seguimiento y a la evaluación, y además expuso su enfoque previsto a raíz de la aprobación del IV PM (28). Sin embargo, esta no constituyó una estrategia de evaluación global como se ha expuesto (véanse los apartados 38 y 39). Además, desde 1996 hasta 2006, la Comisión no efectuó una revisión fundamental de su enfoque de evaluación para los V y VI PM pese a que dichos programas cambiaron tanto en su alcance como en su orientación (véase el apartado 7). En particular, las «direcciones generales de investigación» no han acordado un enfoque coherente para la evaluación de sus programas marco y sus programas constitutivos, que vaya más allá de las obligaciones jurídicas adoptadas en 1999 (para el V PM), en 2002 (en el caso del VI PM) y en 2006 (en el caso del VII PM) (29). |

|

42. |

En el actual período de programación, la ausencia de un enfoque estratégico de este tipo para la evaluación en este ámbito representa un problema particular dada la ejecución conjunta del VII PM por varias direcciones generales, el CEI y las agencias ejecutivas, y la rotación de personal obligatoria impuesta por el Reglamento Financiero en puestos sensibles. Asimismo, contrasta con las prácticas actuales en los ámbitos de la ayuda exterior, que es la segunda mayor área de gestión directa por la Comisión. En este ámbito, las direcciones generales competentes han acordado desde 2002 estrategias de evaluación plurianuales comunes vinculadas a períodos de programación (véase el apartado 52). |

|

43. |

La ausencia de una estrategia de evaluación claramente formulada también difiere significativamente de la situación en los EE.UU. y en Canadá, donde el marco reglamentario impone el establecimiento de tal estrategia (véase el anexo III). |

|

44. |

Como se muestra a continuación, existen diferencias significativas en el alcance e intensidad de las evaluaciones de los programas marco. También había otras deficiencias, tratadas ulteriormente en el presente informe, como problemas de coordinación, diferencias en los enfoques metodológicos, problemas de calendario y deficiencias en la comunicación y el seguimiento de los resultados de evaluación. Todo ello refleja la ausencia de una estrategia de evaluación global para los programas marco. |

Diferencias en el alcance e intensidad de las evaluaciones de los diversos programas marco

|

45. |

Los programas marco se componen de varios programas (y subprogramas) específicos que pueden variar significativamente en cuanto a su finalidad, dinámica subyacente y créditos presupuestarios (en el caso del VII PM, véase el anexo IV). El conjunto de las disposiciones específicas a las distintas decisiones relativas a los programas marco, así como el Reglamento financiero (30) (que prevé la evaluación de los programas y actividades que conllevan gastos significativos), permiten afirmar que, desde el IV PM, existe una obligación legal de evaluación, tanto del programa marco en su conjunto, como de la mayor parte de sus programas constitutivos específicos. |

|

46. |

La Comisión no ha establecido una norma que prevea cuándo deben evaluarse los programas o subprogramas específicos del programa marco, ni ha definido un umbral común a partir del cual esta evaluación sea obligatoria. Ello ha generado divergencias de interpretación sobre el objeto y el nivel de detalle de las evaluaciones:

|

|

47. |

Por consiguiente, en la evaluación quinquenal de 2004, secciones importantes de los programas del IV PM y del V PM no se evaluaron en absoluto (correspondientes al 30 % de la totalidad de los créditos presupuestarios en el caso del IV PM y al 50 % en el caso del V PM). Ello significa que la Comisión no cumplió las disposiciones en materia de evaluación previstas por el artículo 27 del Reglamento financiero. |

|

48. |

Estas divergencias de interpretación de las exigencias legales mínimas relativas a la evaluación, así como la consiguiente infraevaluación de los programas marco que se produjo en el pasado, reflejan la falta de coordinación y el efecto de la ausencia de un enfoque estratégico para la evaluación de los programas marco por parte de la Comisión. |

Recomendaciones

49. Las «direcciones generales de investigación» deberían elaborar y adoptar, con carácter urgente, una estrategia de evaluación común para los programas marco. Sin ser excesivamente preceptiva, esta estrategia debería comportar un enfoque coherente en cuanto a la evaluación de los programas marco y de sus programas constitutivos. También debería proporcionar orientaciones sobre el nivel mínimo a partir del cual debe llevarse a cabo una evaluación detallada, con el fin de tener en cuenta las particularidades de cada ámbito científico.

Organización de la evaluación de los programas marco

|

50. |

La evaluación de los programas marco debe fundamentarse en una estructura organizativa apropiada, que debería estar adaptada a la orientación estratégica de la Comisión en materia de esta evaluación. El Tribunal verificó en qué medida la estructura organizativa garantizaba que el sistema de evaluación estuviera correctamente coordinado, contara con recursos suficientes y que las partes interesadas lo considerasen suficientemente independiente. |

Comisión

Varias direcciones generales ejecutan los programas marco conjuntamente, mientras que la responsabilidad de la evaluación está descentralizada

|

51. |

En la Comisión, la evaluación de los programas de gasto compete a cada dirección general (véase el apartado 8) y en ellas se han creado unidades de evaluación, con el objetivo de planificar, coordinar y llevar a cabo las evaluaciones. |

|

52. |

El hecho de que no exista un órgano de coordinación específico ni una entidad única para la evaluación del conjunto de los programas marco, como por ejemplo una oficina de evaluación conjunta para las «direcciones generales de investigación», representa una particularidad con respecto a otros ámbitos políticos. En el caso de las ayudas exteriores, se creó una unidad de evaluación conjunta para tres direcciones generales (Desarrollo, Relaciones Exteriores y EuropeAid) que se hizo cargo de la evaluación de los programas de desarrollo de la Comisión en terceros países (véase el apartado 42). |

|

53. |

La Dirección General de Investigación, a través de la «red de evaluación IDT» interna de la Comisión, se encarga del intercambio de conocimientos entre las unidades de evaluación de las distintas direcciones generales, pero carece de competencias para definir unas exigencias mínimas de evaluación. No obstante, este mecanismo ha resultado insuficiente para garantizar una coordinación apropiada de la evaluación de los programas marco realizada por la Comisión. |

|

54. |

En 2000 y en 2002, y de nuevo en 2007, la Comisión revisó su enfoque general en materia de evaluación (véase el apartado 14). Aunque no se observaron mejoras importantes en la forma de planificar, concebir y ejecutar las evaluaciones de los programas marco y de sus programas constitutivos, en términos generales las «direcciones generales de investigación» han cumplido los requisitos formales a nivel de la Comisión. |

El papel de los servicios centrales de la Comisión: establecimiento de normas, pero sin capacidad de control en su aplicación

|

55. |

Los servicios centrales de la Comisión (en particular, la Dirección General de Presupuestos y la Secretaría General) proporcionan asesoramiento en cuanto a la metodología, definen unos estándares comunes para el conjunto de la Comisión y supervisan el modo en que las direcciones generales y servicios aplican dichos estándares (véanse los apartados 14 y 70). No obstante, no pueden imponer el modo en que se han de llevar a cabo las evaluaciones en la práctica. |

|

56. |

La experiencia en los EE.UU. y en Canadá refleja que el control del cumplimiento de las normas por los organismos encargados de definirlas contribuye activamente a garantizar el funcionamiento eficaz del sistema de evaluación. En estos dos países, departamentos federales establecen y hacen respetar el marco que permite finalmente apreciar el éxito de un programa (véase el anexo III). A pesar de que los contextos sean diferentes, sus sistemas se basan sin embargo en el mismo principio subyacente según el cual un organismo distinto del que ejecuta el programa debe evaluar ciertos aspectos de la concepción del sistema de evaluación y examinar de forma detallada su eficacia. Una situación análoga puede observarse en algunos Estados miembros [por ejemplo: Francia (31), España (32) y Alemania (33)], en los que organismos externos supervisan las evaluaciones llevadas a cabo por las agencias de financiación o incluso realizan ellos mismos estas evaluaciones. |

Paneles de expertos

Paneles de expertos externos: obligatorios desde el IV PM en virtud de la legislación relativa a los programas marco

|

57. |

Desde el IV PM, los principales ejercicios de evaluación (y el seguimiento anual) de los programas marco deben ser llevados a cabo por (o con el apoyo de) paneles de expertos externos (véase el anexo II). Pese a las dificultades que representa encontrar expertos competentes, estos paneles permiten aportar transparencia, ofrecer cierto grado de independencia, facilitar la participación de las partes interesadas y explotar los conocimientos obtenidos de los propios programas marco, de la evaluación y de las cuestiones científicas subyacentes. |

|

58. |

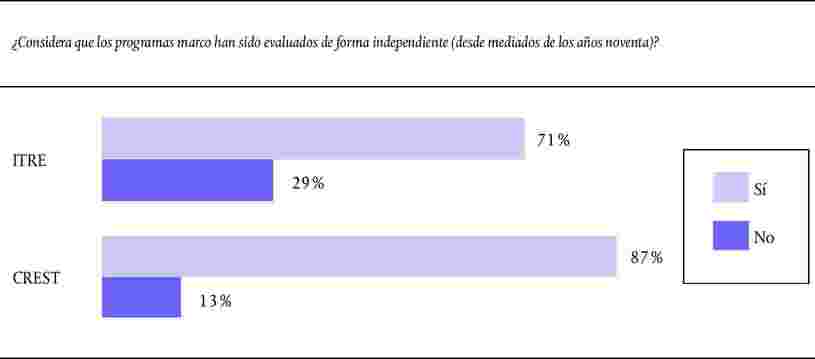

Estos aspectos positivos se vieron confirmados por las encuestas del Tribunal, a las cuales las personas interrogadas respondieron que el sistema de evaluación de la Comisión basado en paneles de expertos proporcionaba una garantía de independencia (véase el gráfico 4).

|

Deficiencias del enfoque basado en paneles de expertos aplicado por la Comisión

|

59. |

Pese a esta impresión positiva, como los miembros de los paneles de expertos y las partes interesadas señalaron al Tribunal durante la fiscalización, el recurso a estos paneles por la Comisión para la evaluación de los programas marco ha adolecido de las deficiencias siguientes:

|

Recursos

Ningún recurso ha sido específicamente asignado a la evaluación de los programas marco

|

60. |

Los fondos necesarios para la evaluación se proporcionan anualmente, en función de las necesidades formuladas por las direcciones generales que ejecutan los programas marco. En la actualidad, esta financiación se obtiene a partir de una combinación de recursos a nivel de la Comisión procedentes de la Dirección General de Presupuestos y de recursos de la parte funcionamiento del presupuesto a nivel de las direcciones generales de que se trate. Además se financian medidas específicas como acciones indirectas a partir del presupuesto operativo de los programas marco. Por lo tanto, no se dispone de una cantidad específicamente afectada a la evaluación. |

|

61. |

En 2006 la media de personal dedicado al ámbito de la evaluación y de la gestión por actividades a nivel de la Comisión es estimaba en torno al 1 % del total (37). Las cifras correspondientes a las actividades de seguimiento y evaluación de los programas marco de IDT en las direcciones generales de Investigación y de Sociedad de la Información eran del 1,2 % y 1,3 % respectivamente. En el caso de la Dirección General de Investigación, no obstante, más de dos tercios de estos recursos de personal estaban asignados a los servicios de programas operativos y no a la unidad de evaluación, y la evaluación solo era una de las múltiples tareas que debían realizar. |

Financiación de la evaluación de los programas marco inferior a la recomendada por la Comisión

|

62. |

Los recursos destinados a la evaluación también pueden expresarse en forma de porcentaje del conjunto de los créditos presupuestarios asignados al programa. Las cifras obtenidas durante la fiscalización indican que, en el caso de los programas de investigación en los Estados miembros de la UE, este porcentaje se sitúa en la práctica entre un 0,1 % y un 2 %. Las directrices de la Comisión sugieren que el 0,5 % del presupuesto de un programa debería destinarse a la evaluación (38). Sin embargo, en el caso de los programas de gran envergadura, podría resultar suficiente una contribución menor de sus presupuestos gracias a las economías de escala. |

|

63. |

La comparación entre las cifras de la Comisión relativas a los gastos destinados a la evaluación durante el período 2003-2006 y los créditos presupuestarios de cada dirección general muestra que la media global se sitúa en torno al 0,15 %, nivel considerablemente inferior al sugerido por la Comisión. Un análisis más detallado sobre el ejercicio 2006 revela que la Dirección General de Sociedad de la Información gastó en evaluación unas cuatro veces más que la Dirección General de Investigación, en relación con el importe de los créditos que gestiona cada una. Además, en la Dirección General de Investigación, solo se destina a evaluación el equivalente al 0,7 % del trabajo de un agente a tiempo completo por millón de euros del presupuesto anual. En comparación, la Dirección General de Sociedad de la Información dedica a esta actividad el doble de esta cantidad. |

|

64. |

Como refleja el presente informe, los esfuerzos suplementarios de la Dirección General de Sociedad de la Información se han traducido en una evaluación de alcance más completo (véanse los apartados 13 y 46) y, como indica la muestra de estudios de evaluación examinada por el Tribunal, en la aplicación de metodologías mejor adaptadas a las necesidades en materia de evaluación (véase el apartado 84). |

|

65. |

Una estimación de costes realizada por el Tribunal, basándose en datos facilitados por la Comisión, muestra que un sistema de evaluación basado en las propuestas formuladas en el presente informe representaría, en promedio, menos del 0,4 % de los créditos presupuestarios del VII PM. Esta financiación cubriría los costes de los paneles y de la subcontratación de estudios, también los gastos relativos al personal de la oficina de evaluación conjunta y a las actuales unidades específicas de evaluación de las direcciones generales, así como otros costes varios (39). |

Recomendaciones

66. Las «direcciones generales de investigación» deberían contemplar la creación de una oficina de evaluación conjunta que se sumaría a las unidades de evaluación existentes en cada dirección general. En consonancia con las prácticas actualmente en vigor en otros ámbitos políticos, esta oficina podría coordinar las actividades de evaluación de la Comisión para el programa marco en su conjunto. Estas funciones comunes de apoyo ya se recomendaron en el pasado para las direcciones generales que gestionan los programas marco (40) y pueden cobrar mayor importancia en el futuro con la creación del CEI y la delegación de la ejecución del programa a las agencias ejecutivas. 67. La Comisión debería seguir recurriendo a los paneles de evaluación como apoyo de sus actividades de evaluación. Sin embargo, debería encontrar un medio para adaptar la estructura del panel a la estructura general del programa marco. Para ello, se recomienda que los paneles se encarguen de programas específicos y, en caso necesario, de subprogramas (véase el anexo IV). Además, estos paneles deberían constituirse con tiempo suficiente para proporcionar un apoyo eficaz a la Comisión, que se prolongaría durante el período de programación y posteriormente. 68. La Comisión debería reexaminar los recursos destinados a la evaluación de los programas marco y de sus programas constitutivos.

Metodologías y técnicas de evaluación

|

69. |

Para que una evaluación resulte eficaz, es necesario utilizar metodologías y técnicas apropiadas. El Tribunal verificó si existían directrices específicas para la evaluación de los programas marco, si las necesidades de información habían sido correctamente analizadas a su debido tiempo y si se habían facilitado a los evaluadores los datos pertinentes. Tomando en consideración los estudios de evaluación llevados a cabo por (o por cuenta de) la Comisión, el Tribunal examinó si las técnicas utilizadas para los distintos estudios proporcionaban una base suficiente para abordar las cuestiones definidas en las evaluaciones quinquenales. También se tuvo en cuenta la contribución potencial de las evaluaciones nacionales a la evaluación de los programas marco. |

Establecimiento de normas y directrices específicas a los programas marco

|

70. |

La Dirección General de Presupuestos ha publicado varias comunicaciones en las que se presenta su política de evaluación y que proporcionan normas para su aplicación, ha establecido asimismo una serie de normas para el conjunto de la Comisión (véanse los apartados 14 y 55) (41). Para otras políticas, las direcciones generales competentes también han elaborado guías específicas de evaluación (42). |

|

71. |

Sin embargo, en el caso de los programas marco la situación es distinta. La Comisión ha publicado (o financiado) varias guías y cajas de herramientas metodológicas para las actividades de evaluación en el ámbito de la investigación (43). Sin embargo, estos documentos no proporcionan orientaciones específicas sobre la manera de evaluar los programas marco, ni indican cómo deben utilizar los agentes de la Comisión o los expertos externos los conceptos clave o la terminología. Estas deficiencias han contribuido a generar los problemas que se exponen a continuación. |

Necesidades de información y obtención de datos

Análisis insuficiente de las necesidades de información

|

72. |

Las «direcciones generales de investigación» no han prestado la debida atención a la definición de los datos necesarios para la evaluación y el seguimiento. En lugar de efectuar un análisis sistemático y detallado de las necesidades de información, la Comisión especificó exigencias en materia de datos ya avanzado el período de programación y sin tener debidamente en cuenta las necesidades globales de evaluación. El cuestionario socioeconómico del VI PM fue la única tentativa común a todas las direcciones generales para ponerse de acuerdo sobre estos datos (véase el apartado 76). Sin embargo, este cuestionario se finalizó en 2004 (transcurridos tres años desde el inicio del período de programación) y básicamente abarcaba aspectos como la participación de ambos sexos y el impacto medioambiental, en lugar de realizaciones científicas (como cuestiones de propiedad intelectual, publicaciones, etc.), logros o impactos. |

|

73. |

La evaluación de los programas depende en gran medida de la disponibilidad de tres tipos de datos:

|

|

74. |

De hecho, la Comisión debería poder facilitar los dos últimos tipos de datos. Sin embargo, a raíz de problemas en los sistemas internos informáticos de la Comisión, que constituyen la principal fuente de información sobre la gestión de los programas y sobre los participantes (44), han surgido en la práctica dificultades importantes a este respecto (45). |

|

75. |

Este hecho queda reflejado en los retrasos considerables que se han producido en la presentación de los informes previstos por el artículo 173 y de los informes anuales de seguimiento (demoras de hasta 16 meses en el caso de los primeros (46) y de hasta siete meses en el de los segundos, durante el período 2002-2005). Dada esta transmisión considerablemente tardía de la información, su utilidad fue limitada. |

Enfoque ineficaz para obtener de los participantes datos destinados a la evaluación

|

76. |

A partir del V PM, la Comisión obligó sistemáticamente a los participantes, mediante contrato, a proporcionar los datos necesarios para medir la realización de los objetivos del programa en términos de realizaciones, logros e impactos. En concreto, los participantes debían:

|

|

77. |

Estas obligaciones contractuales para la comunicación de datos han impuesto cargas administrativas innecesarias para los participantes. Por ejemplo, con respecto al cuestionario anual del VI PM, los datos se recopilan con una frecuencia mucho mayor que la necesaria y basándose en el conjunto de los participantes en los proyectos, cuando bastaría con una muestra representativa. Esta situación puede provocar cierto «cansancio evaluador». Además, esta información se ha recabado en un momento inadecuado; en efecto, dado que muchas de las cuestiones subyacentes para las que se han obtenido los datos presentan un carácter a medio o largo plazo, la recopilación de datos durante la duración contractual del proyecto resulta forzosamente prematura (47). Ello explica que, en la práctica, los resultados producidos por estos instrumentos no hayan tenido gran utilidad para las evaluaciones del V PM y del VI PM. |

|

78. |

Sin embargo, ninguno de los sistemas en vigor prevé la obtención de información de un modo estandarizado una vez finalizado un proyecto (o poco después de su finalización). Las partes interesadas entrevistadas sugirieron que esta información también podría abarcar la realización de los objetivos de los proyectos, los resultados que se espera obtener (así como los imprevistos) y la percepción del valor añadido comunitario por los participantes. Asimismo, dicha información podría constituir la base para el examen por expertos externos de los proyectos finalizados (48). |

|

79. |

Junto con la intensificación del uso de los enfoques cienciométricos (como el análisis de citas) para evaluar los resultados de los proyectos (véase el apartado 83), este podría constituir el punto de partida para la transición de la Comisión hacia un sistema de financiación basado en los resultados para las acciones de IDT cofinanciadas por la Comunidad (49). |

Otras fuentes de datos utilizadas de forma inadecuada

|

80. |

Otras fuentes de datos existentes en la Comisión y en los Estados miembros no son suficientemente utilizadas [por ejemplo, las bases de datos de los programas nacionales de IDT y de los organismos de financiación y el «Servicio de Información Comunitario sobre Investigación y Desarrollo» (CORDIS) establecido por la Oficina de Publicaciones de la Comisión (50)]. |

Estudios de evaluación realizados por la Comisión

Informes examinados por el Tribunal

|

81. |

El Tribunal examinó 86 estudios de evaluación realizados por (o por cuenta de) la Comisión desde 2000. Estos comprendían los 36 estudios que formaron la base de la evaluación quinquenal publicada en 2004, así como otros 50 estudios realizados desde entonces. De los mismos, solo 23 estudios pueden considerarse como verdaderas evaluaciones de los programas marco y de sus programas (véase el gráfico 5). Gráfico 5 Visión general de los estudios de evaluación realizados por (o por cuenta de) la Comisión en el período 2000-2006

|

Evaluaciones más centradas en cuestiones de seguimiento que en logros e impactos

|

82. |

El Tribunal efectuó un metaanálisis de estos estudios de evaluación específicos del que se desprenden principalmente dos observaciones:

|

El desarrollo de metodologías innovadoras no ha sido objeto de atención suficiente

|

83. |

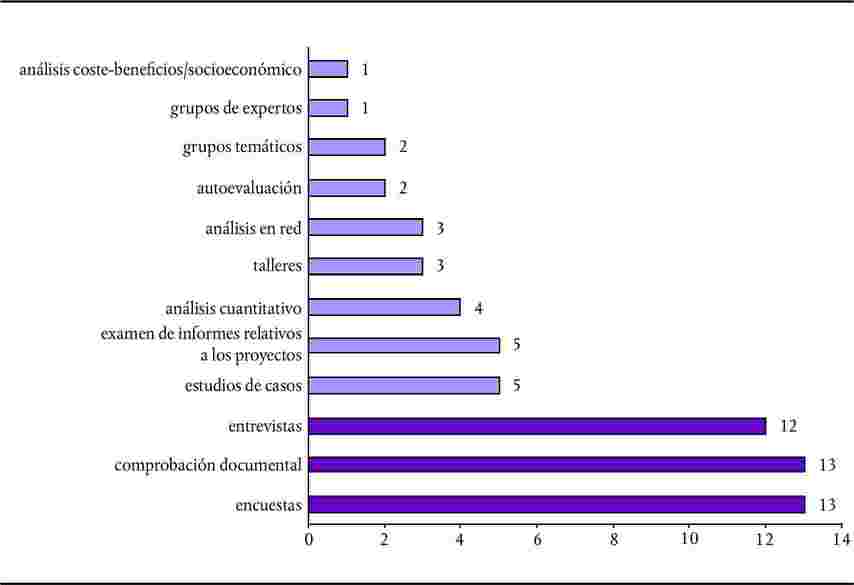

En las evaluaciones realizadas en el período 2000 a 2006 predomina la utilización de metodologías y de técnicas tradicionales (en particular, encuestas, comprobación documental y entrevistas) (véase el gráfico 6). Por otra parte, no se emplearon (o solo muy rara vez) otras metodologías y técnicas de evaluación avanzadas, aunque bien implantadas, en particular:

|

|

84. |

Solamente en un número limitado de casos se utilizaron estudios de evaluación que intentaran resolver algunas de las dificultades metodológicas en la evaluación de la intervención pública en materia de investigación (véase el anexo I):

|

|

85. |

En la opinión de las partes interesadas entrevistadas por el Tribunal, la utilidad y la pertinencia de las evaluaciones de la Comisión podría mejorar. Esto demuestra la necesidad de un mayor desarrollo metodológico para que el sistema de evaluación tenga en cuenta el carácter cambiante de los programas marco (véase el apartado 7) (57). |

Los temas de importancia planteados por las evaluaciones quinquenales no pudieron tratarse sobre la base de los estudios de evaluación específicos de la Comisión

|

86. |

Esta constatación también se ve reflejada por los importantes problemas a los que el panel de expertos encargado de la evaluación quinquenal de 2004 (58) se vio confrontado para responder a las preguntas de evaluación sugeridas en el mandato. En muchos casos resultó totalmente imposible examinar estas preguntas de importancia, debido a que no existían estudios sobre el tema realizados previamente por (o por cuenta de) la Comisión y a que los miembros del panel de expertos no tuvieron la posibilidad de encargar estos estudios oportunamente (véase el gráfico 7). Gráfico 7 Cuestiones tratadas en el marco de las evaluaciones quinquenales de 2004

|

|

87. |

Además, se constató que los miembros del panel solo pudieron contestar las preguntas mencionadas en el mandato cuando estas correspondían a aspectos para los que se habían definido unos objetivos claros y cuantificables en los programas (como la proporción de pequeñas y medianas empresas participantes). |

Evaluaciones de los programas marco realizadas a nivel nacional

|

88. |

Varios Estados miembros y países asociados realizan sus propias evaluaciones nacionales de los programas marco, abordando cuestiones pertinentes e interesantes desde su propio punto de vista (59). En los últimos ocho años, se han presentado catorce estudios de estas características en nueve Estados miembros y un país asociado. |

|

89. |

Si bien la Comisión fomentaba el recurso, siempre que fuese posible, a unos enfoques normalizados, estos estudios nacionales de impacto son muy heterogéneos (60). Por consiguiente, dado que no siguen una metodología armonizada, las posibilidades de agregar, combinar o comparar los resultados son limitadas. Además, dado su carácter nacional, estos estudios solo permiten reflejar parcialmente la dimensión de cooperación europea. |

|

90. |

En su Libro Verde de 2007 sobre el Espacio Europeo de Investigación, la Comisión hizo hincapié en la importancia de disponer, a nivel del EEI, de unos análisis rigurosos sobre el impacto y la eficacia de las acciones y políticas de investigación, en particular de los Estados miembros y de la UE. Esta institución reconoció también que los sistemas y estructura actuales no resultaban adecuadas para afrontar este desafío, puesto que cada nivel de intervención realizaba sus evaluaciones por separado (61). |

Recomendaciones

91. La Comisión debería elaborar un manual para la evaluación de las actividades financiadas por los programas marco, que contuviera definiciones de los conceptos clave y de la terminología e indicara una serie de metodologías apropiadas para ciertas actividades de evaluación. Este manual debería basarse en las guías y cajas de herramientas existentes, así como ser actualizado con regularidad. 92. La Comisión debería definir sus necesidades de información, teniendo en cuenta la necesidad de limitar la carga administrativa de los participantes. 93. La Comisión debería proporcionar, a su debido tiempo, información sobre el seguimiento de la ejecución de los programas marco. Como prevén las «normas de participación» del VII PM, deberían resolverse urgentemente los problemas relativos a los sistemas informáticos de la Comisión para la utilización de los datos relativos a la gestión de los programas y a los participantes. 94. Las obligaciones de los participantes de presentar informes a la Comisión deberían reducirse significativamente y las encuestas deberían realizarse únicamente sobre la base de muestras representativas. La obligación contractual de presentar, para cada proyecto, datos sobre el impacto basados en indicadores, debería sustituirse por una breve autoevaluación una vez finalizado el proyecto. 95. Al llevar a cabo sus evaluaciones, la Comisión debería utilizar en mayor medida fuentes complementarias de datos que sean de relevancia (existentes tanto en sus propios servicios como en los Estados miembros). 96. La Comisión debería emplear toda la gama de técnicas de evaluación disponibles. Además, debería fomentar el desarrollo de enfoques innovadores para abordar las dificultades metodológicas inherentes a la evaluación de la intervención pública en materia de investigación (véase el anexo I), así como recurrir a estos enfoques en sus propias evaluaciones. 97. La Comisión debería buscar, en colaboración con los Estados miembros, la forma de potenciar los beneficios de las evaluaciones de los programas marco efectuadas a nivel nacional.

Difusión y utilización de las constataciones de evaluación

|

98. |

La evaluación debería proporcionar información y análisis pertinentes que puedan utilizarse de forma eficaz para la gestión de los programas y la elaboración de políticas. En particular, debería constituir el punto de partida para una reflexión en profundidad sobre los puntos fuertes y las insuficiencias de una intervención pública, requisito indispensable de todo aprendizaje. El Tribunal verificó si las evaluaciones tenían lugar a su debido tiempo, si las constataciones se comunicaban y difundían a las partes interesadas externas a la Comisión y si esta institución tomaba en consideración las recomendaciones para revisar los programas en curso («programas de aprendizaje»). |

La programación de las evaluaciones no tuvo en cuenta el tipo de información que cabría haber esperado de forma realista

|

99. |

El Tribunal reconoce que ciertos tipos de análisis exigen una perspectiva a largo plazo (por ejemplo, la evaluación de los logros y del impacto socioeconómico) y que algunos aspectos están vinculados a un período de programación específico (por ejemplo, los objetivos del programa, incluso en un ámbito científico determinado), mientras que otros no lo están (véase el gráfico 8). Sin embargo, en sus actividades de evaluación la Comisión no ha adoptado un enfoque que tome en consideración estos horizontes temporales. |

|

100. |

Ateniéndose a la legislación, las principales actividades de evaluación de la Comisión deben centrarse exclusivamente en los cinco años anteriores a la evaluación quinquenal, abarcando de este modo apartados relativos a dos períodos de programación sucesivos. Así pues, apenas se han abordado los efectos y el impacto a medio y largo plazo. Por consiguiente, las evaluaciones quinquenales por lo general se han centrado esencialmente en aspectos de seguimiento, en cuestiones de concepción de los programas a corto plazo y en observaciones generales sobre la orientación de los programas marco. El Tribunal acoge favorablemente el hecho de que la legislación relativa al VII PM ya no prevea las evaluaciones quinquenales, ni ningún otro período predefinido que la evaluación deba abarcar. Gráfico 8 Cuestiones de seguimiento y de evaluación examinadas en función de distintos horizontes temporales

|

||||||||||||||||||||||||||

|

101. |

Los expertos de la Comisión también han constatado insuficiencias en las evaluaciones quinquenales para evaluar los logros y los impactos de los programas marco:

|

|

102. |

La cuestión de la realización en tiempo oportuno también afecta a las evaluaciones específicas impuestas por la legislación. Por ejemplo, el «informe Marimón» de 2004, en el que se analizaron los nuevos instrumentos introducidos en el VI PM (2003-2006), fue encargado demasiado pronto, por lo que faltaban, o no eran suficientes, la experiencia práctica y las pruebas empíricas en las que basar sus conclusiones (65). |

Comunicación y difusión

|

103. |

Por iniciativa propia, la Comisión puede elaborar y adaptar los programas de trabajo operativos en función de ciclos a corto plazo, sujetos a la aprobación del comité del programa competente. Ello podría constituir una ocasión para proceder a ajustes en la gestión del programa y también en la reasignación de presupuestos en los subprogramas. Sin embargo, no se han hallado elementos justificativos de que la Comisión haya recurrido a esta posibilidad (véase el apartado 107). |

|

104. |

Con esta salvedad, y dada la forma en que los programas marco se conciben y adoptan, resulta casi imposible para la Comisión realizar cambios importantes como la modificación de los objetivos de los programas o la reasignación de presupuestos entre subprogramas. Solo el legislador puede promulgar modificaciones de tan amplio alcance en el marco de una revisión de la legislación del programa marco (como en 2010 para el FP7) o de la adopción del programa marco subsiguiente. Por este motivo, generalmente la legislación dispone que los principales ejercicios de evaluación se programen de forma que sus resultados tengan la mayor utilidad posible para la elaboración de las políticas. |

|

105. |

Algunos de los principales usuarios de las evaluaciones de la Comisión son las propias «direcciones generales de investigación» (66). No obstante, la legislación relativa a los programas marco también impone explícitamente que estas evaluaciones se comuniquen al Parlamento Europeo y al Consejo. |

|

106. |

En la encuesta realizada por el Tribunal a miembros de la comisión ITRE del Parlamento Europeo y del comité CREST del Consejo, la mayor parte de los encuestados indicaron sin embargo que no se consideraban lo suficientemente informados de la ejecución y de los resultados de los programas marco (véase el gráfico 9) (67).

|

Seguimiento de las constataciones de evaluación

|

107. |

En sus revisiones de evaluación anuales, la Comisión presenta un resumen de constataciones y medidas adoptadas a raíz de sus evaluaciones (68). En lo que respecta al seguimiento, la Comisión también ha proporcionado respuestas formales a sus constataciones y recomendaciones de las evaluaciones quinquenales y las evaluaciones específicas impuestas por la legislación y, en la medida de lo posible, ha tomado medidas apropiadas para solventar las deficiencias constatadas. No obstante, no sucedió así en muchos de los otros informes de evaluación examinados y nada indica que las constataciones y recomendaciones se tomaran en consideración para modificar los programas de trabajo. Las declaraciones presupuestarias relativas al principio de presupuestación por actividades y los informes anuales de actividad de las direcciones generales tampoco señalan en qué medida se actuó sobre la base de las constataciones de las evaluaciones. |

Recomendaciones

108. La Comisión debería definir el tipo y el alcance de la evaluación que razonablemente cabe esperar para las fechas fijadas en la legislación (2008, 2010 y 2015), explicar de qué modo podrían utilizarse las evaluaciones para adaptar los programas («programas de aprendizaje») y especificar cuál puede ser la contribución de las evaluaciones a las decisiones políticas. En particular, la Comisión debería precisar el enfoque previsto en la evaluación de los resultados a más largo plazo de los programas marco actuales y precedentes, dado que dichos resultados quizá tarden entre siete y diez años en concretizarse (véase el gráfico 8). 109. La Comisión debería examinar sus prácticas en materia de comunicación y difusión de sus constataciones de evaluación a fin de que las partes interesadas reciban la información necesaria. En particular, las «direcciones generales de investigación» deberían proporcionar una respuesta formal a todas las evaluaciones y publicar estos estudios a su debido tiempo, junto con sus respuestas. Las «direcciones generales de investigación» también deberían notificar el seguimiento realizado en sus declaraciones presupuestarias relativas al principio de presupuestación por actividades y en sus informes anuales de actividad, así como inspirarse en las recomendaciones para actualizar los programas de trabajo y concebir los futuros programas.

CONCLUSIÓN GENERAL

|

110. |

El Tribunal reconoce que la evaluación de los programas de IDT y, en particular, la valoración de sus resultados a largo plazo, presenta dificultades inherentes, por lo que cuesta definir las mejores prácticas en la materia. |

|

111. |

El Tribunal estima que la evaluación resulta esencial para la gestión de los programas, para la planificación futura y para la elaboración de las políticas. La evaluación también proporciona una base para la obligación de rendir cuentas y constituye una fuente de valiosa información sobre los resultados previstos (o imprevistos) que se han logrado, la medida en que se han alcanzado los objetivos de los programas, la pertinencia y utilidad de los programas y el grado de eficiencia y eficacia en la ejecución de los mismos. Dado que en el caso de los programas marco la orientación general, las cuestiones presupuestarias y la concepción de los programas son competencia del Parlamento Europeo y del Consejo, se precisa un sistema de evaluación transparente, creíble y sólido para que estas instituciones puedan disponer de la información apropiada. |

|

112. |

En 2000 y en 2002, la Comisión estableció un marco general de evaluación, que posteriormente revisó en 2007. Aunque durante el período examinado por el Tribunal no se observaron importantes mejoras en el modo en que se planificaron, concibieron y ejecutaron las evaluaciones de los programas marco y sus programas constitutivos, en términos generales las «direcciones generales de investigación» han cumplido los requisitos formales a nivel de la Comisión. |

|

113. |

Durante el período objeto del presente informe, y como exigía la legislación relativa a los programas marco, las «direcciones generales de investigación» disponían de un sistema de evaluación y la Comisión puede presentar un considerable volumen de estudios de evaluación. No obstante, persiste el hecho de que la información sobre la consecución de los objetivos de los programas y de resultados de los programas marco, en su conjunto, continúa siendo escasa o inexistente debido a que por lo general las evaluaciones se han centrado en cuestiones de ejecución de los programas a corto plazo. Por consiguiente, las evaluaciones efectuadas por la Comisión han sido de poca utilidad para los responsables de tomar decisiones políticas, para las partes interesadas y para la propia Comisión. |

|

114. |

Dada la importancia de la evaluación para la gestión de los programas y la elaboración de las políticas, el enfoque de la evaluación de los programas marco y de sus programas constitutivos adoptado por la Comisión debe ser reexaminado teniendo en cuenta los nuevos desafíos políticos, el incremento de financiación, la ampliación de la orientación de la política de investigación de la Comunidad y la reciente reforma de la Comisión. En su informe de 2007, EURAB hacía la misma recomendación. |

|

115. |

El Tribunal considera que la utilización de una lógica de intervención explícita en la concepción de los futuros programas que integren los programas marco se traduciría en unos programas mejor orientados y estructurados. También contribuiría a la política «Legislar mejor» de la Comisión, cuyo fin consiste en crear un entorno reglamentario mejor diseñado, más simple, más eficaz y más comprensible (69). |

|

116. |

La evaluación de los programas marco y de sus programas constitutivos sería más eficaz si los objetivos e indicadores de los programas fueran más claros desde el inicio, si las «direcciones generales de investigación» acordaran una estrategia de evaluación sólida, pero no excesivamente preceptiva, y si se aplicaran unas metodologías de evaluación más avanzadas, entre las que figurasen los enfoques cuantitativos. |

|

117. |

El Tribunal también observó varios aspectos en los que la Comisión podría revisar la estructura organizativa relativa a la evaluación de los programas marco. Las ventajas serían:

|

|

118. |

Las recomendaciones que se formulan en el presente informe están basadas en prácticas existentes en la Comisión, o en buenas prácticas internacionales. En lo que respecta a los recursos, es evidente que la introducción del enfoque sugerido para la evaluación de los programas originaría un aumento de los costes. Sin embargo, el Tribunal estima que muy probablemente este aumento generará una contrapartida financiera positiva de un valor como mínimo equivalente. |

El presente informe ha sido aprobado por el Tribunal de Cuentas en Luxemburgo, en su reunión del día 22 de noviembre de 2007.

Por el Tribunal de Cuentas

Hubert WEBER

Presidente

(1) Según la OCDE, la investigación y el desarrollo pueden definirse como «[…] trabajo de creación realizado de manera sistemática con el fin de aumentar el conjunto de los conocimientos, incluido el conocimiento del hombre, de la cultura y de la sociedad, así como la utilización de dicho conjunto de conocimientos para nuevas aplicaciones» (véase OCDE, Manual de Frascati — Método tipo para realizar encuestas sobre la investigación y desarrollo experimental, París, 2002, p. 30). En el contexto comunitario, el acrónimo IDT se utiliza para referirse tanto a la tecnología, como a la investigación y al desarrollo.

(2) La Dirección General de Investigación es la principal dirección general encargada de la gestión y coordinación de los programas marco. Otras cinco direcciones generales también se ocupan de la gestión (parcial) de los programas específicos, siendo la más importante la Dirección General de Sociedad de la Información y Medios de Comunicación (seguida de la Dirección General de Energía y Transportes, la Dirección General de Empresa e Industria, la Dirección General de Pesca y el Centro Común de Investigación de la Comisión).

(3) En 2000, el Consejo Europeo de Lisboa fijó el objetivo de hacer de la UE, para la próxima década, la economía basada en el conocimiento más dinámica, competitiva y sostenible, que permita asegurar el pleno empleo y una mayor cohesión económica y social.

(4) En 2002, el Consejo Europeo decidió que la inversión global en IDT y en innovación en la Unión Europea deberá aumentar con el fin de alcanzar el 3 % del PIB para el 2010. Además, precisó que la parte financiada por el sector privado deberá alcanzar los dos tercios del total [véase Comisión Europea, «Invertir en investigación: un plan de acción para Europa»; Comunicación de la Comisión al Consejo, al Parlamento Europeo, al Comité Económico y Social Europeo y al Comité de las Regiones, COM(2003) 226 final, p. 7].

(5) En el caso de la gestión directa, la Comisión efectúa las operaciones necesarias para su ejecución presupuestaria, sin intervención de los Estados miembros o de terceros países en los que residen los beneficiarios del gasto.

(6) A partir de 2006, solo en el VI PM han sido más de 22 000 entidades jurídicas públicas y privadas las participantes, por lo general en el marco de consorcios que reunían a varios socios.

(7) Se trata de un método de cooperación basado en el principio de cooperación intergubernamental voluntaria. Se fundamenta particularmente en el aprendizaje mutuo, la realización de una evaluación comparativa y la participación de las mejores prácticas.

(8) Reglamento (CE, Euratom) no 1605/2002 del Consejo, de 25 de junio de 2002 (DO L 248 de 16.9.2002, p. 1), artículos 27, 48, 59 y 60.

(9) Comisión Europea, Dirección General de Presupuestos, Comunicación a la Comisión de la Sra. Grybauskaitė con el acuerdo del Sr. Presidente, «Responding to strategic needs: reinforcing the use of evaluation», SEC(2007) 213, 21 de febrero de 2007; Comisión Europea, Dirección General de Presupuestos, Comunicación a la Comisión de la Sra. Schreyer, «Focus on Results: Strengthening Evaluation of Commission Activities», SEC(2000) 1051, de 26 de julio de 2000.

(10) Decisión no 1982/2006/CE del Parlamento Europeo y del Consejo, de 18 de diciembre de 2006, relativa al Séptimo Programa Marco de la Comunidad Europea para acciones de investigación, desarrollo tecnológico y demostración (2007 a 2013) (DO L 412 de 30.12.2006, p. 1), artículo 7, apartado 1; la información de seguimiento que deberá facilitar la Comisión a los comités de programa se define en las decisiones relativas a los programas específicos [véase por ejemplo la Decisión 2006/971/CE del Consejo, de 19 de diciembre de 2006, relativa al programa específico «Cooperación» por el que se ejecuta el séptimo programa marco de la Comunidad Europea de acciones de investigación, desarrollo tecnológico y demostración (2007-2013) (DO L 400 de 30.12.2006, p. 86) artículo 8, apartado 4, y anexo V].

(11) Comisión Europea, Comunicación al Consejo relativa a un plan de acción de la Comunidad respecto a la evaluación de actividades de investigación y desarrollo de la Comunidad entre los años 1987 y 1991, COM(86) 660 final, de 20 de noviembre de 1986, en respuesta a la resolución del Consejo de 28 de junio de 1983.

(12) Comisión Europea, «Evaluación quinquenal de los programas marco de IDT de la Unión Europea, 1992-1996», informe del grupo de expertos independientes presidido por el vizconde Davignon (1997); Comisión Europea, «Evaluación quinquenal de los programas marco de IDT de la Unión Europea, 1995-1999», informe del grupo de expertos independientes presidido por Joan Majó (julio de 2000); Comisión Europea, «Evaluación quinquenal de los programas marco de investigación de la Unión Europea, 1999-2003», informe del grupo de expertos independientes presidido por Erkki Ormala (15 de diciembre de 2004).

(13) Comisión Europea, «Evaluación de la efectividad de los nuevos instrumentos del VI programa marco», 21 de junio de 2004, informe de un grupo de expertos de alto nivel presidido por el Dr. Ramón Marimón.

(14) Comisión Europea, Dirección General de Presupuestos, Comunicación a la Comisión de la Sra. Schreyer, «Focus on Results: Strengthening Evaluation of Commission Activities», julio de 2000, SEC(2000) 1051; Comisión Europea, Dirección General de Presupuestos, Comunicación a la Comisión del Sr. Presidente y de la Sra. Schreyer, «Evaluation Standards and Good Practice», C(2002) 5267, 23 de diciembre de 2002.

(15) Comisión Europea, Dirección General de Presupuestos, Comunicación a la Comisión de la Sra. Grybauskaitė con el acuerdo del Sr. Presidente, «Responding to strategic needs: reinforcing the use of evaluation», SEC(2007) 213, 21 de febrero de 2007.

(16) Comisión Europea, documento de trabajo, «Impact assessment and ex-ante evaluation» SEC(2005) 430.

(17) La Comisión «Industria, Investigación y Energía» (ITRE) del Parlamento Europeo es (en particular) responsable de la política industrial, de la política de investigación (incluida la difusión y explotación de los resultados en materia de investigación), de la política espacial, de las actividades del Centro Común de Investigación, del Tratado Euratom, así como de la sociedad de la información y la tecnología de la información.

(18) El Comité CREST («Comité de la Recherche Scientifique et Technique» — Comité de Investigación Científica y Técnica) fue creado mediante una Resolución del Consejo de 14 de enero de 1974 y está formado por representantes de las instancias nacionales responsables de las políticas científicas y tecnológicas de los Estados miembros. El CREST es un comité consultivo, y su misión consiste en proporcionar información a la Comisión y al Consejo sobre temas relativos, en particular, a la coordinación de las políticas nacionales de I+D y también participa en el seguimiento y evaluación de los programas marco.

(19) Los modelos lógicos, que muestran cómo los recursos empleados en las diferentes actividades conducen a los resultados deseados, constituyen el medio más apropiado para ilustrar la lógica de intervención. Estos modelos permiten explicar con claridad las hipótesis subyacentes a la forma de concebir un programa y de subdividir los objetivos generales en objetivos operativos.

(20) Comisión Europea, Dirección General de Presupuestos, «Evaluación de las actividades de la UE: guía práctica para los servicios de la Comisión», julio de 2004, páginas 87 y 106.

(21) «Evaluación quinquenal de los programas marco de investigación de la Unión Europea, 1999-2003», informe del grupo de expertos independientes presidido por Erkki Ormala (15 de diciembre de 2004): apartado 6 «Evaluating the Framework Programme», p. 19.

(22) Los países beneficiarios de la ayuda exterior deben presentar marcos lógicos para su financiación comunitaria (Comisión Europea, Aid delivery methods, volumen 1, «Project cycle management guidelines», marzo de 2004, sección 5: «The logical framework approach»).

(23) Reglamento (CE, Euratom) no 1605/2002, artículo 27, apartado 3.

(24) En 2006, el ámbito político «08 investigación» se estructuró sobre la base de los programas (y subprogramas) específicos del período de programación actual del VI PM (por tanto, fue preciso sustituir esta estructura por otra distinta en 2007); en cambio, en lo que respecta al ámbito político «09 sociedad de la información», los programas específicos actuales y precedentes se agruparon en un único principio de presupuestación por actividades (Comisión Europea, Dirección General de Investigación, Dirección A: Coordination of Community activities, Planning, programming, evaluation, Annual Management Plan 2006, 20 de diciembre de 2005; Comisión Europea, Dirección General de Sociedad de la Información y Medios de Comunicación, Plan de gestión anual 2006, 23 de diciembre de 2005).

(25) En el caso de la Dirección General de Investigación, los objetivos de la gestión por actividades (y los indicadores utilizados para medir su realización) cambiaban cada año. En cambio, la Dirección General de Sociedad de la Información disponía de objetivos plurianuales, que sin embargo diferían de los objetivos del programa (o de los que habían sido especificados en el programa de trabajo).

(26) Comisión Europea, Servicio de Auditoría Interna, Review of effectiveness and efficiency of the SPP/ABM cycle, Secretaría General y Dirección General de Presupuestos, 2005: apartado 4.1, p. 31.

(27) Comisión Europea, «Comunicación de la Comisión al Consejo relativa a un plan de acción comunitario para la valoración de los programas de investigación y desarrollo comunitarios», COM(83) 1 final, 19 de enero de 1983.

(28) Comunicación de la Comisión al Consejo y al Parlamento Europeo, «Seguimiento y evaluación externos e independientes de actividades comunitarias en el ámbito de la investigación y el desarrollo tecnológico», 22 de mayo de 1996 [COM(1996) 220 final].

(29) Cada dirección general que ejecuta un programa marco documenta sus evaluaciones planificadas en planes anuales (y plurianuales) de evaluación. Sin embargo, estos documentos de planificación no pueden considerarse como una verdadera estrategia de evaluación.

(30) Reglamento (CE, Euratom) no 1605/2002, artículo 27, apartado 4.

(31) «Loi de programme pour la recherche no 2006-450» con fecha de 18.4.2006 y «Décret no 2006-1334 relatif à l'organisation et au fonctionnement de l'Agence d'évaluation de la recherche et de l'enseignement supérieur (AERES)» con fecha de 3.11.2006.

(32) Agencia Nacional de Evaluación y Prospectiva que depende del Ministerio de Educación y Ciencia: Orden ECI/1252/2005 de 4 de mayo de 2005, en virtud de la cual se crea la Comisión Asesora de Evaluación y Prospectiva.

(33) En 2004, el «Deutsche Forschungsgemeinschaft» (DFG) creó un instituto especializado, el «Institut für Forschungsinformation und Qualitätssicherung» (IFQ), y le confió la responsabilidad de desarrollar y normalizar las metodologías de evaluación, la garantía de calidad y de realizar evaluaciones de las acciones de IDT financiadas por el DFG.

(34) Para el VII PM, la Comisión creó 15 grupos consultivos de expertos, frente a los 12 grupos para el VI PM y a los 17 grupos para el V PM. Estos grupos consultivos de expertos asesoran a la Comisión sobre cuestiones vinculadas a la política y a los programas en el contexto de los programas marco. Sin embargo, debe tenerse en cuenta que dichos grupos no encajan plenamente en la estructura de los programas marco, es decir, que no hay un grupo consultivo de expertos para cada programa (o subprograma) específico.